飞行的蜗牛

飞行的蜗牛 分布式存储 Categories

- 技术杂谈 21

- Database 7

- Docker 4

- PHP 5

- 随笔杂谈 8

- 前端开发 7

- FunnyTools 8

- Jekyll 1

- 读书笔记 7

- Java 9

- SpringBoot 4

- 区块链技术 15

- IPFS 5

- C/C++ 1

- Filecoin 32

- Golang 2

- Sharding-JDBC 3

- 分布式存储 11

- Lotus-源码系列 8

- Lotus 1

- 框架源码系列 1

- Spring-源码系列 4

- AI 8

- ChatGPT 4

- Stable Diffusion 2

- DeepSeek-R1 1

- DeepSeek-V3 1

岸见一郎 -- 被讨厌的勇气

这个世界世界给了你什么,那是你决定不了的。但是怎么看待,怎么利用你手里的东西,确是你可以决定的。

本文我们接着上文继续来探讨一下如何使用使用 PHP 来操作 Ceph S3 接口。

尼采

凡不能毁灭你的,必将使你强大。

前面我们分别讲了

岸见一郎 -- 被讨厌的勇气

这个世界世界给了你什么,那是你决定不了的。但是怎么看待,怎么利用你手里的东西,确是你可以决定的。

本文介绍如何给 Ceph 存储池配置 SSD 缓存池。

神啊,

请赐予我宁静,好让我能接受,我无法改变的事情;

请赐予我勇气,好让我能改变,我能去改变的事情;

请赐予我睿智,好让我能区别,以上这两者的区别。

本文总结一些 Ceph 的常用运维命令

# 环境说明

- 操作系统: Ubuntu 18.04 LTS

- Ceph 版本: 12.2.12 Luminous (stable)

- 节点架构: 1 mon(ceph1), 1 mgr(ceph1), 1 mds(ceph1), 3 osd(ceph1, ceph2, ceph3)

本文讲述 Ceph 块设备存储的相关介绍以及 RBD 相关操作。

# 什么是块设备?

首先,块是一个字节序列(例如,一个 512 字节的数据块)。

块设备是 I/O 设备中的一类,是将信息存储在固定大小的块中,每个块都有自己的地址,

还可以在设备的任意位置读取一定长度的数据。最常见的块设备例如硬盘,U盘,SD卡等。

做一个不是很准确的但是方便你理解的概括:块设备就是以块作为存储单位的设备。

# 存储池介绍

Ceph 对集群中所有存储资源进行池化管理,pool 是一个逻辑上的概念,其表达的是一组数据存储和查找的约束条件。

Ceph 集群刚刚搭建成功之后会有系统内会默认创建一个 RBD 存储池(然而本人测试的 Luminous 版本却发现并没有默认的 RBD)。

Ceph 提供两种类型的存储池,多副本存储池(Replicated Pool) 和 纠删码存储池(Erasure Code Pool)。

鲁迅

怯者愤怒,却抽刃向更弱者。

本文介绍如何搭建 Ceph 分布式存储集群。如果对于 Ceph 基本架构还不了解的同学,请移步

尼采

每一个不曾起舞的日子,都是对生命的一种辜负。

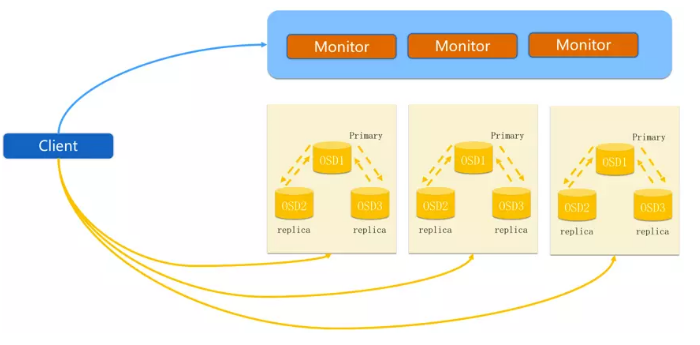

首先看下 Ceph 整体架构图简图:

默认每个主 OSD 都携带两个副本。有效存储比例为 3:1 。 在写入的时候也是先写入到主分区(Primary OSD),然后在自动同步到副本(Replicate OSD)。

卢梭

人生而自由,又无往不在枷锁之中。

Filecoin 的测试正在如火如荼的进行。面对即将到来的第二期测试,各路玩家都使出了浑身解数。

到本文发布为止, Lotus 测试网全网算力已经达到 1.3 PB,头部矿工的算力已经有 500 多TB。

有不少同学在 Slack 上问我,说他们是怎么存储这么多数据的,即使把48盘位的矿机满盘位做 raid5 也不可能有这么大的存储空间。

要实现这种超大数据盘,就得使用分布式存储系统了,比如我们接下来要说的 Ceph。