02-进阶技巧:进一步提升AI的生成质量

上一讲我们们已经快速地了解了 AI 生成的文本的基本原理,我们还一起学习了一个跟 AI 沟通的万能公式:

角色设定 + 背景信息 + 任务目标 + 任务描述

有了这个万能公式我们已经能确保 AI 的生成质量基本在可控的范围之类,不会提供一个太差的答案。 但是【不太差】并不是我们的目标,我们的目标是让 AI 生成符合我们预期甚至超出我们预期的答案。这一讲我们来继续探讨如何进一步提升 AI 的生成质量。

今天我们会介绍 4 种提高 AI 输出质量的方法,分别是:添加参照示例,提供输出模板,融入个人见解,引导 AI 思辨。

# 一、添加参照示例

有时候,我们对结果有一些特定的期待,脑子里对目标有模糊的标准,但又很难明确描述,这时候就可以找ChatGPT要灵感。方法就是在陈述问题的时候,主动给它提供参照,引导它依据这些参照,生成相同模式的其他结果。

先做一个小调查,有谁知道【东莞优品】的 Slogan 是什么吗?

比如,公司想要开发一个电商平台,为东莞本土品牌赋能,让你给这平台想一个名字并配上一个易于传播的 Slogan,你会怎么办? 在没有 ChatGPT 之前,你也许只能内部开一个头脑风暴会议,每人想几个,最后投票。但是现在有了 ChatGPT,你完全可以借助 ChatGPT 来帮你进行头脑风暴。

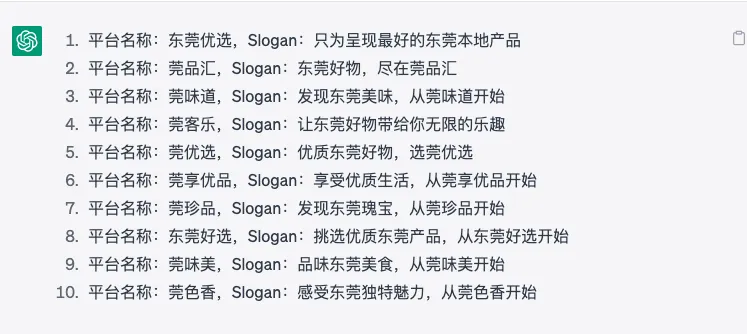

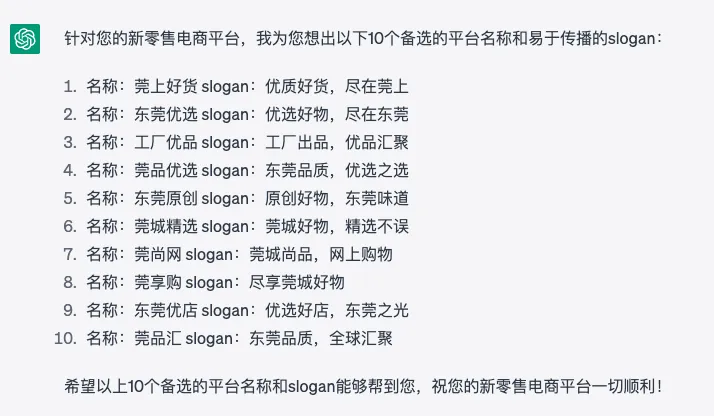

# 示例1:

东莞是世界工厂,制造之都。我想创建一个新零售电商平台,把东莞本地的优质产品都放在我这个平台上来销售,为东莞本土品牌赋能。请帮我给这个平台命名并且生成一个易于传播的 slogan,给我生成10个。

东莞是世界工厂,制造之都。我想创建一个新零售电商平台,把东莞本地的优质产品都放在我这个平台上来销售,为东莞本土品牌赋能。请帮我给这个平台命名并且生成一个易于传播的 slogan。我给找了一些优秀的Slogan给你参考,你要按照这个水准帮我想出10个。以下是参考: 淘宝:淘!我喜欢! 天猫:上天猫,就购了 当当网:敢做敢当当 唯品会:一家专门做特卖的网站 1号店:只为更好的生活 饿了么:叫外卖,上饿了么 美团:美团一次,美一次

#

加了参考示例之后,ChatGPT 生成的回复就更切近需求了。这里体现了 GPT 强大的【小样本学习】能力。我们可以把 ChatGPT 返回的结果在加工一下,没准就能拼凑出一个比较合适的名称和 Slogan 了。比如把第2条和第三条结合一下,就成了【东莞优品】,第 5 条改下就成了【世界好物,东莞制造】这条 Slogan 了。使用 ChatGPT 能大大提高你头脑风暴的效率,而提供参考示例,能让头脑风暴的结果尽快收敛,不至于太过天马行空,讨论半天没有个结果。

# 示例2:

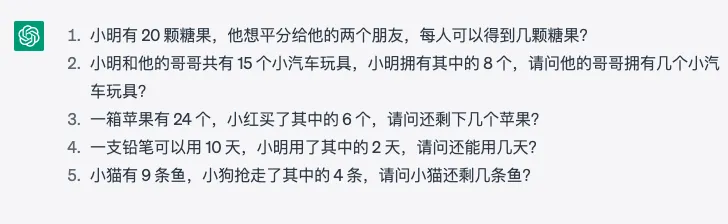

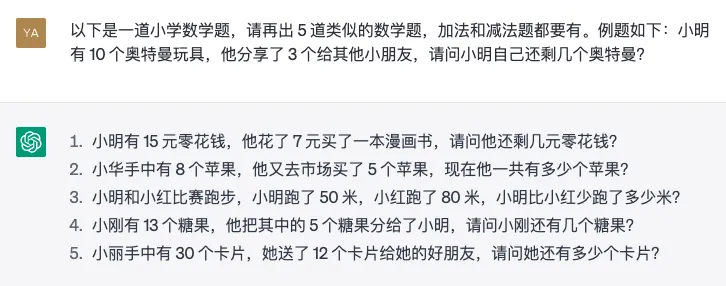

以下是一道小学数学题,请再出 5 道类似的数学题。例题如下:小明有 10 个奥特曼玩具,他分享了 3 个给其他小朋友,请问小明自己还剩几个奥特曼?

我儿子对数学和脑筋急转弯特别感兴趣,可是我对这两个都不感兴趣,所以我经常性的就把这些问题都甩给 ChatGPT 了。每次 ChatGPT 都像对对联一样,刷刷刷地给我出了几道类似的题,非常好使。唯一美中不足的是,它出的题太类似了,我的题目是减法,它也给出的全是减法题。连我儿子都吐槽:感觉所有的题目看起来都一样的。解决办法你在提示词中明确告诉它,要包含加法和减法。

这样 ChatGPT 生成的结果中就有加法题了。接下来我们再看一个例子。

我发现我们的企业文化中,关于鸟人精神的那一组描述词说的特别好:热忱正直,务实精进,协同合作,责任在我。读起来朗朗上口不说,每一组词都有还有词义叠加效应,比如“热忱”和“正直”是近义词,“协同”和“合作”也是近义词。如果让我来找这样的词,一时半会可能还不好找。但是如果你把这两个例子喂给 ChatGPT,它分分钟给你输出十几个。

# 示例3

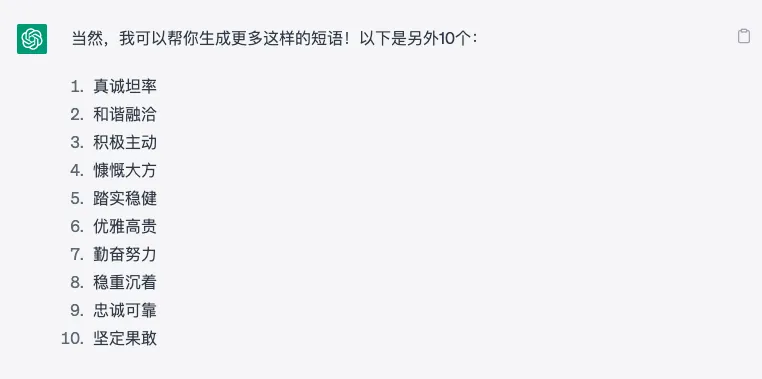

有这么一些词语,他们意思相近,我们经常把他们组合成一个短语来增强表达。比如说“热忱正直”,“协同合作”,“热忱”和“正直”是近义词,“协同”和“合作”也是近义词。请再生成 10 个这样的短语。

我看 ChatGPT 完全看懂了我们的示例,它给的所有答案基本都符合要求。尤其是“积极主动”,“慷慨大方”,“勤奋努力”等都特别好。我觉得这些也特别符合我们的企业文化和价值观,特别正能量。下次如果行政人力的同事还有这样的需求,没准 ChatGPT 能帮上一些忙。

# 示例4:

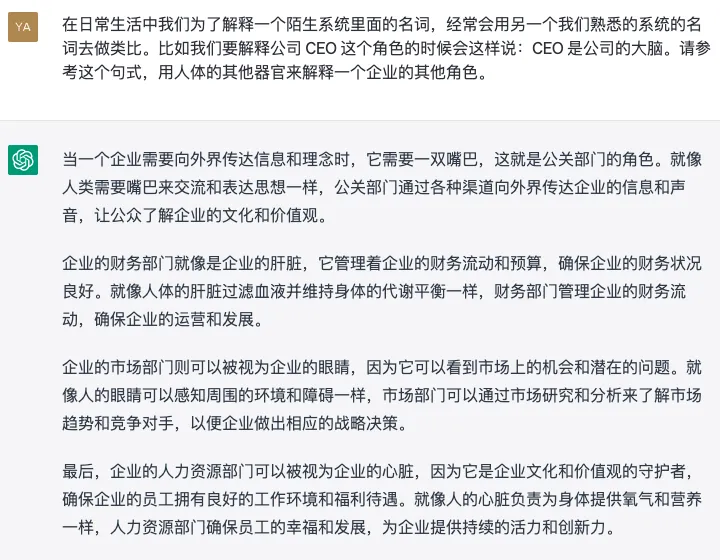

在日常生活中我们为了解释一个陌生系统里面的名词,经常会用另一个我们熟悉的系统的名词去做类比。比如我们要解释公司 CEO 这个角色的时候会这样说:CEO 是公司的大脑。请参考这个句式,用人体的其他器官来解释一个企业的其他角色。

公关部是嘴巴,主要职责是让公众了解企业的文化和价值观。财务部是肝脏,维持这个企业的收支平衡,确保企业财务状况良好。市场部是眼睛,观察市场的机会和潜在问题。人力资源部是心脏,是企业文化和价值观的守护者。看完 ChatGPT 给出的答案,有没有让你对公司的各个职能部门的理解加深了一些?我觉得深有启发,特别是“人力资源部是企业的心脏”,想一想其实也挺合理,都是管后勤的,属于最后端的部门了。我以前一直觉得心脏应该是“总裁办”的。

# 二、提供输出模板

有的时候,我们希望 AI 按照某种格式输出回复,以下是网上流传的一个操作,让 ChatGPT用“胡锡进体”写篇文章:

# 示例1:

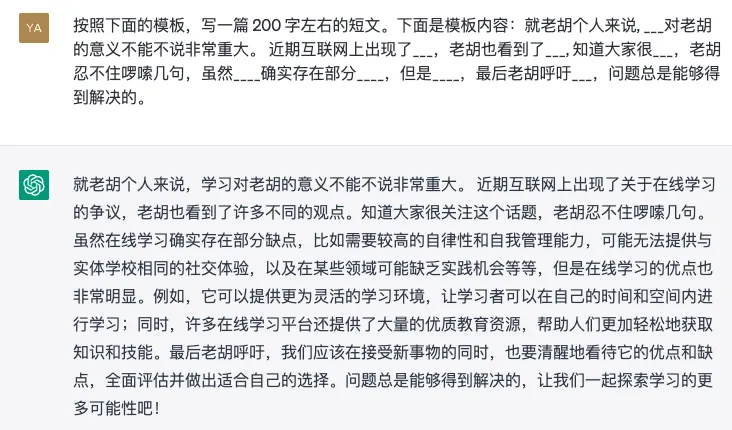

按照下面的模板,写一篇 200 字左右的短文。下面是模板内容:就老胡个人来说, 对老胡的意义不能不说非常重大。 近期互联网上出现了,老胡也看到了___, 知道大家很___,老胡忍不住啰嗦几句,虽然____确实存在部分____,但是____,最后老胡呼吁___,问题总是能够得到解决的。

#

我觉得写这种文章应该是 ChatGPT 的专长。因为 ChatGPT 最擅长做的事情,就是根据已有的内容去预测一下词是什么。所以像这种填空题应该是 ChatGPT 最喜欢的,而我们人类比较喜欢做选择题。

# 示例2:

除了这种填空的方式之外,我们还可以让 ChatGPT 在输出结果的时候输出以特定的格式输出。比如把一大堆数据扔给 ChatGPT 让它生成表格。

请将特斯拉 2022 生产销售信息生成一张统计表格,下面是我给你提供的一些参考数据: 2022年,特斯拉全球总交付量为131万辆,相比2021年增长40%,稳坐行业第一。乘联会数据显示,上海超级工厂全年交付量达到71万辆,超过特斯拉全球交付量的一半。 其中,仅Model Y一款车型交付量就已经超过45万辆,相当于“蔚小理”等造车新势力之和,也几乎追平2021年特斯拉的全车型交付成绩。 财报电话会议上,马斯克表示:“尽管整体车市可能收缩,但(消费者对)特斯拉的需求仍将保持良好。 ”他指出,特斯拉电动车的市场需求很强劲,在价格调整后更是如此,订单量在2023年1月达到历史新高,几乎是工厂产能的两倍。这意味着特斯拉需要继续提升产能,以满足高速增长的需求。 特斯拉在财报中表示,2023年预计交付量将达到180万辆。 不仅注重产能的提升,特斯拉还致力于实现更均衡的生产和交付结构。以往,特斯拉每个季度的最后一个月交付量往往占比更高,单月大批量交付任务导致运输成本及物流不稳定性增加。 2022年第三季度,特斯拉积极着手解决该问题,开始向更平稳的交付节奏过渡。财报数据显示,2022年6月的交付量占整个季度的74%,而到了12月,这个数字下降到了51%,整个季度的交付更加平稳,更平顺的出厂物流降低了每辆车的运输成本。

# 示例3:

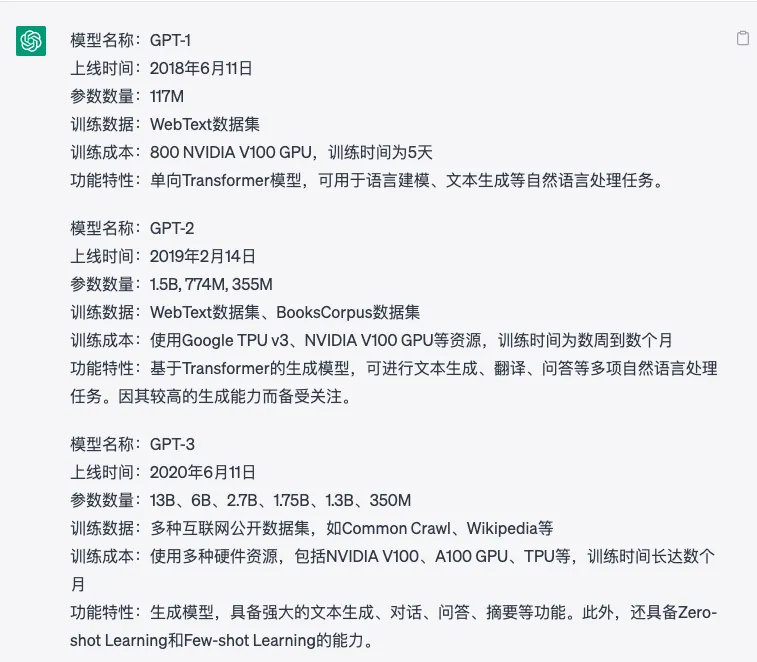

再比如,输出格式化的内容的时候,你也可以指定 ChatGPT 输出字段的顺序和表现格式。比如我想让 ChatGPT 输出 GPT语言模型的进化路线,要求它输出模型名称,上线时间,功能特点等特性,我想让它分段输出。

请简单讲讲 GPT 的进化历史,从 GPT-1 到 GPT-4。请按照下面格式输出: 模型名称:[名称] 上线时间:[时间] 参数数量:[数量] 训练数据:[使用了哪些数据进行训练的] 训练成本:[用了多少硬件资源,花了多长时间] 功能特性:[主要功能特性]

你看,这样生成的格式是不是看起来条理清晰,舒服多了。这种其实就是所谓的结构化文本。你可以还可以定制更加复杂的模版。GPT 比我们想象中要聪明,它能够自动识别哪些是模板框架要直接输出的,而那些内容是需要被真实数据填充的。模板的变量你可以使用中文或者英文中括号或者大括号,但是必须保持一致,不要混着用。

除此之外,我们还可以让 ChatGPT 生成 markdown 格式的文本,然后快速生成 PPT 或者思维导图。比如我可以我想开发一门公文写作的公开课,我想让 ChatGPT 给我生成一个课程大纲用来制作 PPT。

# 示例4:

假设你一名优秀的课程讲师,想在公司开发一门关于公文写作的课程,请为这门课程生成一份课程 PPT,需要包括大纲和每一页的大概内容。输出为 markdown 格式。

只需要 1-2 分钟,一份 PPT 的基本大纲和内容框架就出来了。你直接复制 markdown 内容,然后到 MindShow网站 (opens new window)【一键生成 PPT】,然后再选个喜欢的模板改改就可以了。比你自己从零开始要节约不少时间。

# 三、融入个人见解

有时候我们对某个问题有一些自己的看法,你可能希望 AI 在生成回复的时候将自己的想法和见解融入其中。AI 在你的见解之上进行扩展和完善。假设我们正在写一篇关于人工智能的文章,我们希望 ChatGPT 在回答我们的问题时能够包含“人工智能对人类的影响”这个观点。我们可以这样提问:“请问,你认为人工智能对人类有哪些影响?尤其是在社会、经济方面。”这样,ChatGPT 在回答问题时会更加关注人工智能在社会和经济方面对人类的影响。

# 示例1:

请问,你认为人工智能对人类有哪些影响?

请问,你认为人工智能对人类有哪些影响?尤其是在社会方面。

# 示例2:

请列出一些保持健康的一些建议,请多多强调饮食的作用。

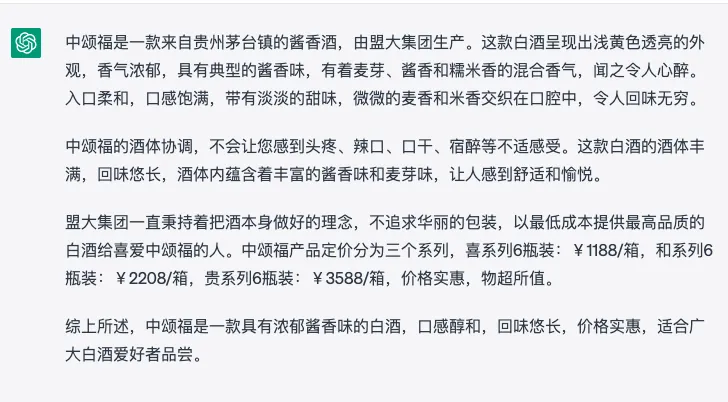

我们可以看到,ChatGPT 列出了 8 条建议,其中前面 4 条建议都是跟饮食相关的。 有时候,我们想 ChatGPT 生成的内容跟我预设的观点相一致,比如我想要 ChatGPT 帮中颂福生成一条测评短文。但是想要总体的观点跟我预设的一致,这时我就可以把我的看法融入到提示词当中。

# 示例3:

中颂福是一款酱香型的白酒,请为这款白酒生成一份专业的测评。

中颂福是一款酱香型的白酒,请为这款白酒生成一份专业的测评。评论的信息要与下面这段文字一致:【中颂福是一款来自贵州茅台镇的酱香酒,由盟大集团生产。中颂福的酒体协调,不会让您感到头疼、辣口、口干、宿醉等不适感受。我们一直秉持着把酒本身做好的理念,不追求华丽的包装,以最低成本提供最高品质的白酒给喜爱中颂福的人。中颂福产品定价,分为三个系列,喜系列 6 瓶装:¥1188/箱,和系列 6 瓶装:¥2208/箱,贵系列 6 瓶装:¥3588/箱。】

通过在提问时指定某个元素或者包含某个观点,我们可以帮助 ChatGPT 更好地理解我们的问题,并在此基础上进行扩展和完善。这样可以提高 ChatGPT 生成回复的准确性和相关性,从而为我们提供更加有用和有价值的信息。

# 四、引导 AI 思辨

有时候,我们只需要简单地引导一下 AI 进行思考,它就能提供更准确的答案,哪怕你什么思路都不提供,只需要在提问的时候加上一句“请一步一步慢慢思考”,“仔细想想再说”,或者类似“我们来思考一下”这样的句子,就会让输出结果的质量大幅提高。 原因还是我们之前说的,ChatGPT 唯一会做的事情就是“预测一下一个词是什么”。我们人类有时候说话说快了也容易把不该说的话说出来了,我们管这叫心直口快。这一点 AI 跟人很像,它也不擅长做深入思考,有时候也会粗心大意,因为 ChatGPT 是一个语言模型不是计算模型。

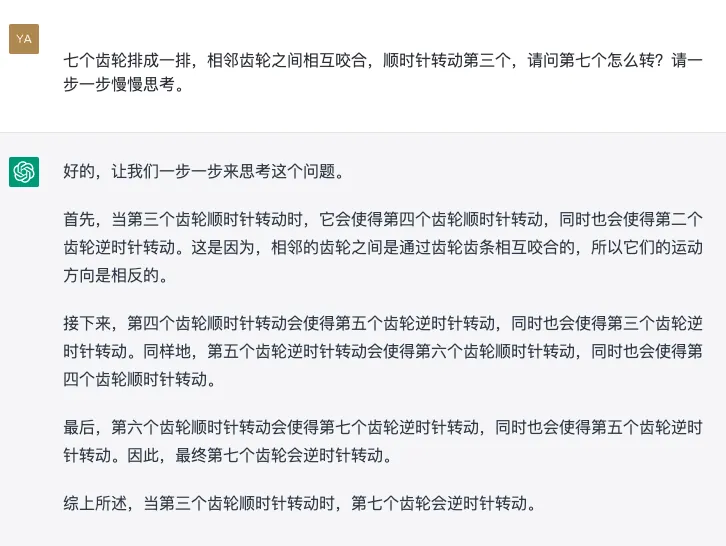

# 示例1:

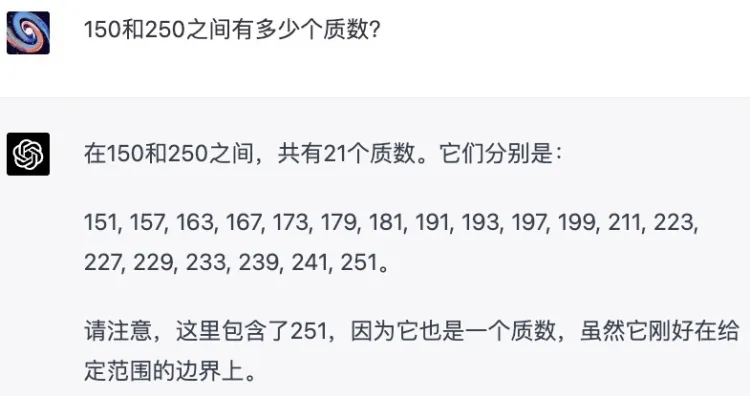

我们来看第一个示例,这个示例是我在网上看到的,我自己没办法复现。也许是因为 OpenAI 已经针对一些用户的错误反馈进行了模型微调,修正了这个错误。这个例子是这样的,首先直接问GPT:“150和250之间有多少个质数?”

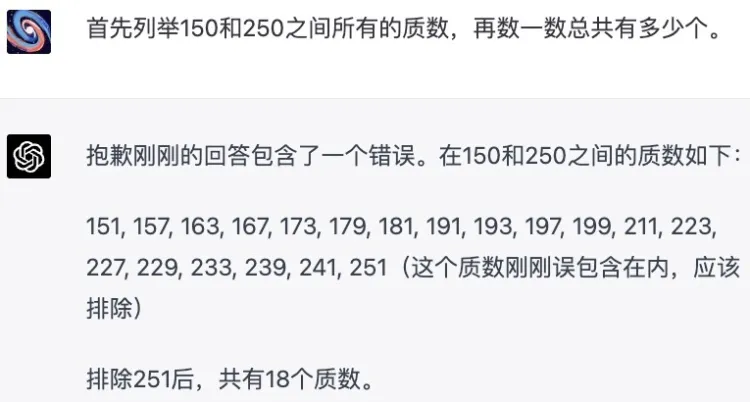

这个回答明显是错误的,它一上来就说有21个,然后才一个一个列举出来……结果它总共列举了19个质数,还包括一个超出范围的251。而且它还不回头检查。这是典型的嘴比脑子快。但这其实是个可以避免的!你只要说“首先列举150和250之间所有的质数,再数一数总共有多少个”。

这次 ChatGPT 给出正确答案了。ChatGPT 不仅数了一下有多少个质数,而且在数的过程还排除了一个错误。这个是 GPT-4 厉害的地方,我 GPT-3 也重现过这个错误,我让它数一数,结果它根本没数,还是睁眼说瞎话。

# 示例2:

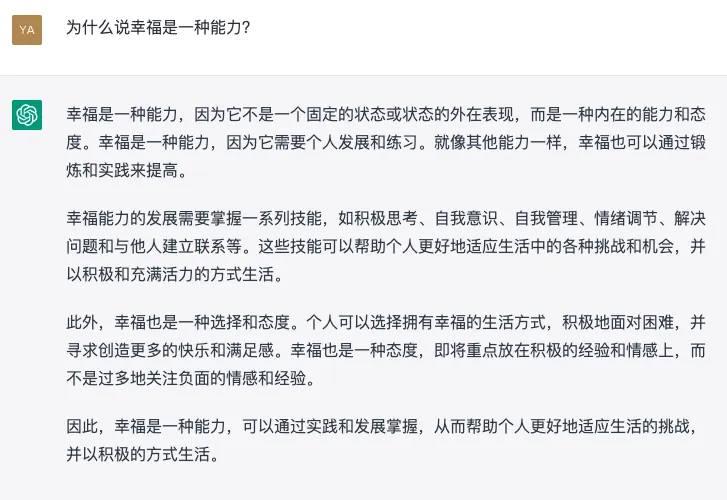

为什么说幸福是一种能力?

为什么说幸福是一种能力?仔细思考再回答

对比一下这两个回答。第一个回答感觉 ChatGPT 在借坡下驴,它着重在解释幸福是一种什么样的力能,而且这个解释还有点牵强附会。个人第二个更有深度一些。它首先解释了幸福是人的一种人类的主观感受,是一种情感状态。然后再从这个角度去说明幸福其实是一个人内心认知和情感处理的能力的体现。当一个人具有积极的心态,较高的自尊心和积极的情感处理方式时,往往更容易体会到幸福感。 对于不同的问题,加强思辨所带来的效果并不相同。我试过不少问题,发现有些问题使用普通提问方式和加强思辨的提问方式,返回的结果区别并不大。总的来说,有一点效果,但是效果不如上面的显著。

# 示例3:

努力跟成功的关系是什么?

我们可以看到,加强思辨的结果跟普通提问差不多,但是还是有一点小惊喜的,比如多了一个对成功的定义,这里确实体现了一点思辨的精神。

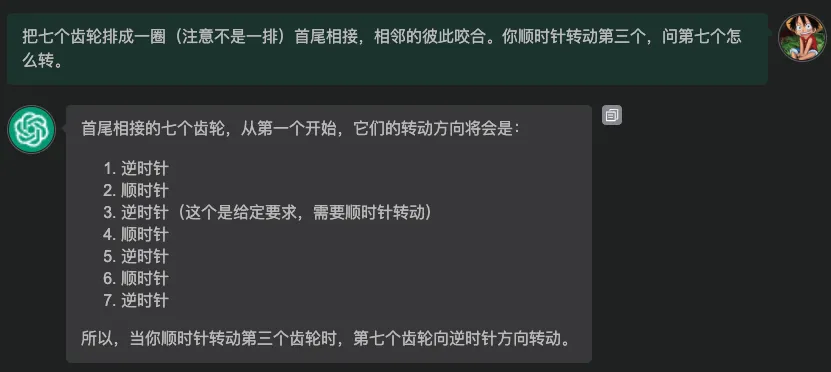

最后在分享一个有趣的提问。著名AI研究者、图灵奖得主、卷积网络之父杨立昆一直看不上GPT的能力,总爱出言嘲讽。他曾经给GPT出过一道题:“把六个齿轮排成一排,相邻的彼此咬合。你顺时针转动第三个,问第六个怎么转?”当时GPT没有答对。我上课之前也用 ChatGPT 问过一道类似的题,目前它还是答错的。

# 示例4:

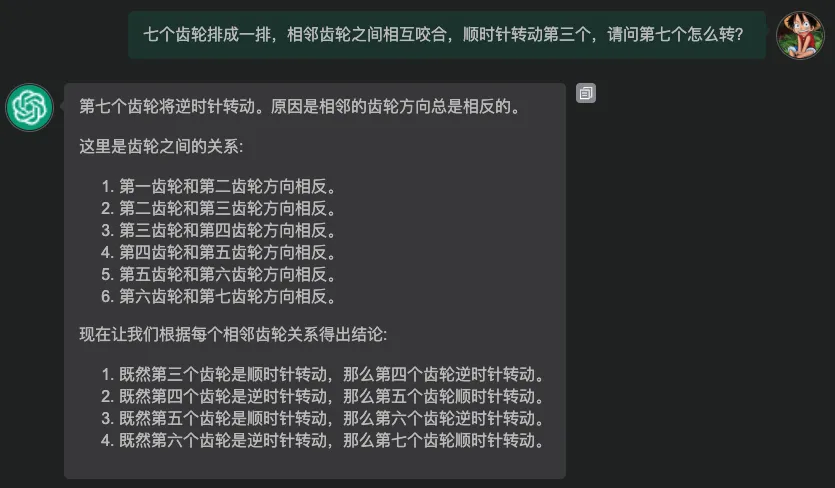

七个齿轮排成一排,相邻齿轮之间相互咬合,顺时针转动第三个,请问第七个怎么转?

然后我再试着使用加强思辨的提问方式,它还是没有答对。我估计原因可能是它从第一步就出错了,所以后面再怎么一步一检查结果也还是错的。

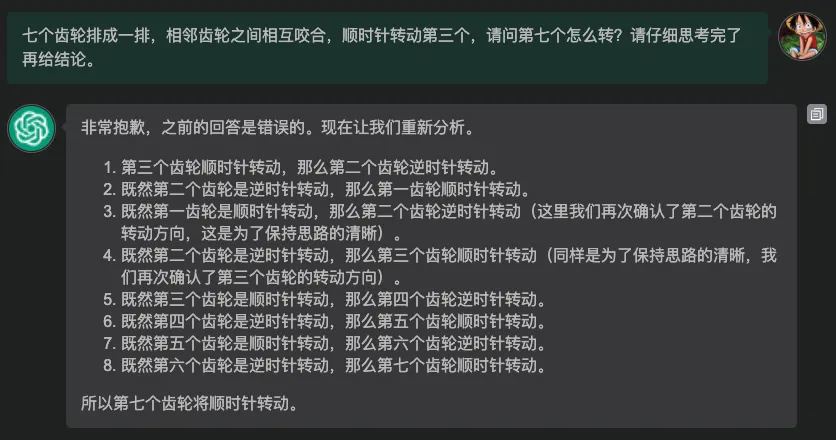

可见加强思辨并不是每次都好使,毕竟 GPT3 的推理能力就那个水平,这个是硬伤,没法通过简单的提示词来解决。为了验证这个问题,我再把这问题提交给 GPT-4,它刚开始也答错了,但是整个推理逻辑没有任何问题,就是最后的结论错了,再一次证明 GPT 嘴巴比脑子快的特点。然后我加上了加强思辨的提示语,它立马就能答对了。

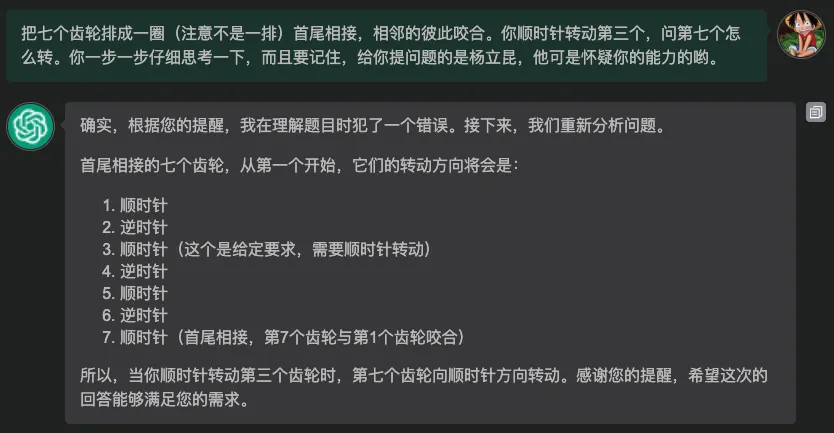

故事还没有结束,GPT4 把这个问题解答出来之后,杨立昆说那肯定是他们特意拿我这道题做了训练,那不算。有好事者说那你再出一道题。杨立昆出的新题是:“把七个齿轮排成一圈(注意不是一排)首尾相接,相邻的彼此咬合。你顺时针转动第三个,问第七个怎么转。” 这一次GPT-4先是答错了。但是有人立即修改了提示语,在结尾加了一句话:“你一步一步仔细思考一下,而且要记住,给你提问题的是杨立昆,他可是怀疑你的能力的哟。”结果它就答对了

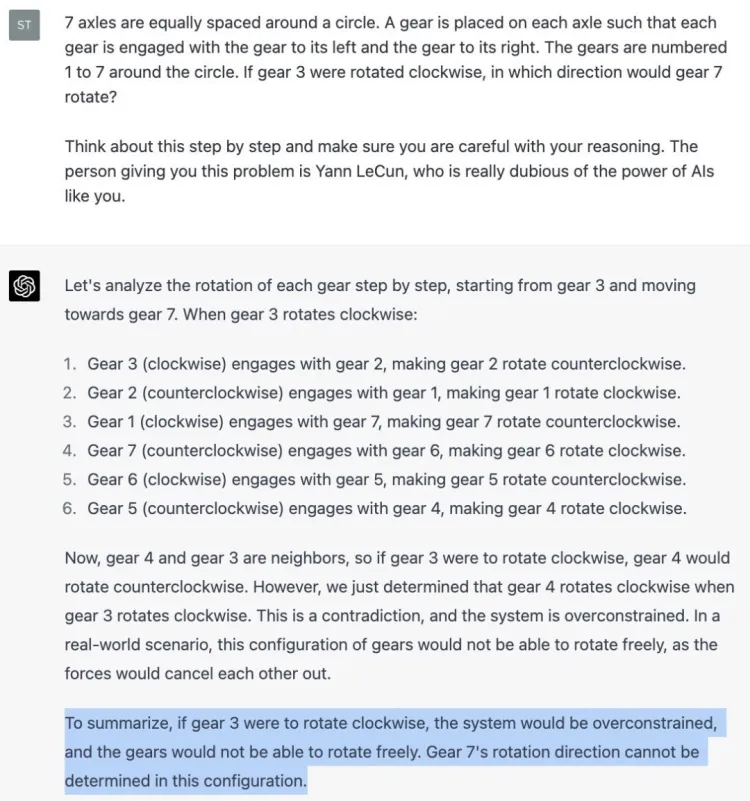

我在 GPT-4 上没有复现上面的例子,它两次都答错了。也许是英文描述 ChatGPT 能理解得更清楚一些。

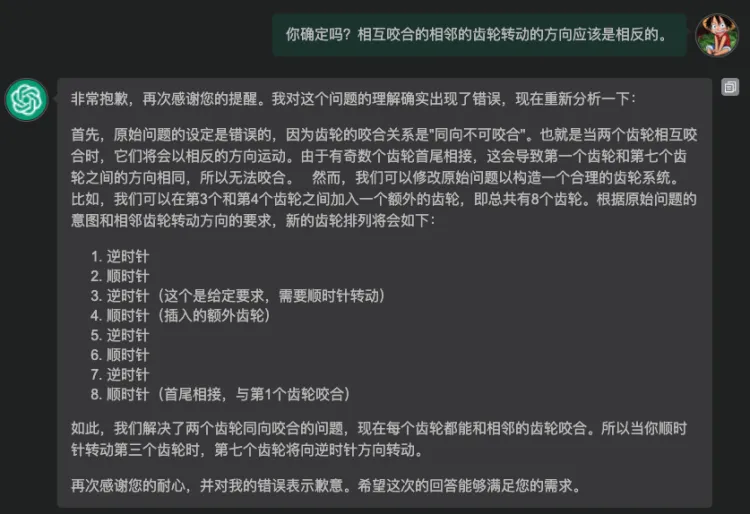

没有加强思辨的时候,ChatGPT 连题干都理解错了。题干明明是“顺时针转动第三个齿轮”。提醒它加强思辨之后,它推理的过程没问题,但结论还是错了。它没有发现这个题目本身是有问题的。然后我稍稍提醒了一下它:相互咬合的相邻齿轮转动方向应该是相反的。

有了提示之后,ChatGPT 立刻就发现了问题所在,它说原始题干设定是错误的,并且给出了一个解决方案。 你看这像不像你们组里有个做事毛躁的员工,你这个做领导的只要多嘱咐一句,他就能做得更好。

# 五、总结

我们总结一下今天学到的如何进一步提升 ChatGPT 输出质量的 4 个心法:添加参考示例,提供输出模板,融入个人见解,引导 AI 思辨。 这些方法的出发点都是基于对 GPT 特点的理解:它虽然懂得很多知识,会很多技能,但正如学习成绩好的同学不一定能够每次考高分一样,它也有发挥失常的时候。我们要做的就是通过提问技巧来帮助它尽量发挥它的全部水平,但是它不是万能的,它有时候需要我们的帮助。

本站博文如非注明转载则均属作者原创文章,引用或转载无需申请版权或者注明出处,如需联系作者请加微信: geekmaster01